L’histoire de l’informatique est justement marquée par la volonté des hommes d’automatiser certaines tâches longtemps réalisées à la main, en particulier le calcul et le traitement d’informations.

Le terme « informatique » date de 1962 et jusqu’à cette date, le mot « informatique » est absent du dictionnaire !

C’est Philippe Dreyfus qui va l’inventer afin de désigner la science des ordinateurs et du traitement d’information. Il vient de la contraction des mots « information » et « automatique ».

En 1966, l’académie française a défini l’informatique comme la ‘’Science du traitement rationnel, notamment par machines automatiques, de l’information considérée comme le support des connaissances humaines et des communications dans les domaines techniques, économiques et sociaux’’.

Des origines de l’informatique

On attribut la paternité de l’ancêtre de la machine à calculer à Blaise Pascal pour son invention de la « Pascaline » mais d’autres machines « calculantes » avaient vues le jour bien avant.

Remonter le temps aux calendes grecs

Considérée comme le premier calculateur analogique antique permettant de calculer des positions astronomiques, la Machine d’Anticythère ou mécanisme d’Anticythère, aurait vu le jour entre – 200 et – 100 avant notre ère.

Sur la base de vestiges d’engrenages en bronze retrouvés lors de fouilles, il a été possible d’en reconstituer son fonctionnement.Ce dispositif mécanique manuel permettait ainsi de pouvoir retrouver ou prévoir une date, et donc de mesurer le temps par rapport à la position de différents corps célestes dans le ciel.

Logique et algorithmes dans l’antiquité

Différentes méthodes de calcul utilisés dans l’antiquité sont parvenues jusqu’à nous, voici quelques exemples :

- Les premiers «algorithmes» connus, datés vers 1800 ans avant Jésus Christ, datent des babyloniens ;

- L’utilisation de bouliers est avérée depuis très longtemps en Asie et en Russie, vers -1000 avant JC en Chine ;

- L’usage d’Abaques, des planches de bois avec des rainures sur lesquelles on fait glisser des cailloux (calculi en latin), en respectant la numérotation de position, est courant dans toutes civilisations méditerranéennes durant l’antiquité ;

- La numérotation décimale et l’usage de Quipus par les civilisations pré-colombiennes et en particulier les Incas jusqu’au XVème siècle

L’imaginaire collectif a conservé en mémoire certains des principes de géométries énoncés par différents philosophes et penseurs grecs comme Pythagore ou Thalès ou l’algorithme d’Euclide mais différentes recherches avancées en mathématiques fondamentales ont également vues le jour dans d’autres civilisations et en particulier en Inde et au moyen-orient.

Sciences et technologies au Moyen-âge

Bien que le moyen-âge ne soit pas vraiment identifiée comme une période de l’histoire ayant donnée naissance à de grandes avancées, elle a permit la découverte et la redécouverte de technologies et de concepts innovants avec la multiplication des contacts et des échanges entre les grandes civilisations européennes, byzantines, arabes, indiennes et asiatiques.

Timbre soviétique émis à l’occasion de son 1200e anniversaire (789-1989) représentant le portrait fictif d’Al-Khwarîzmî

Timbre soviétique émis à l’occasion de son 1200e anniversaire (789-1989) représentant le portrait fictif d’Al-Khwarîzmî

Il faut attendre la consolidation de la recherche fondamentale en mathématiques et plus particulièrement celle liée à l’algèbre et à la logique apparus au 9ème siècle grâce Abu Jaffar Al Khwarizmi.

Avec la traduction en latin des écrits « mathématiques » d’Abu Jaffar Al-Khwârismî à partir du XIIème siècle, les milieux scientifiques européens s’approprient les chiffres arabes, le système décimal et le zero en provenance d’Inde et ses très nombreux concept d’algèbre et de logique. Ses méthodes de calculs seront nommées algorithme à partir de son nom latinisé.

Ainsi, de très nombreuses inventions technologiques et concepts vont voir le jour et se diffuser durant le moyen-âge que ce soit en mathématiques mais aussi et surtout en médecine, en géographie, en astronomie.

L’enseignement « général » au moyen-âge en Europe repose sur l’étude des arts libéraux hérités de l’antiquité grecque (grammaire, rhétorique, dialectique, arithmétique, musique, astronomie et géométrie). La médecine y est parfois ajoutée. Ces « matières », dans le contexte religieux de l’époque, sont obligatoires avant d’aborder les études de philosophie (et de théologie) qui sont assimilées.

La raison engendre la grammaire, puis la dialectique, la rhétorique, ensuite, pour accéder à Dieu, la géométrie, l’astronomie, enfin l’arithmétique.

Propos attribués à Saint Augustin

De cette vision « centrée sur Dieu » découle une recherche biaisée sur une certaine logique divine dans la construction et l’organisation du monde.

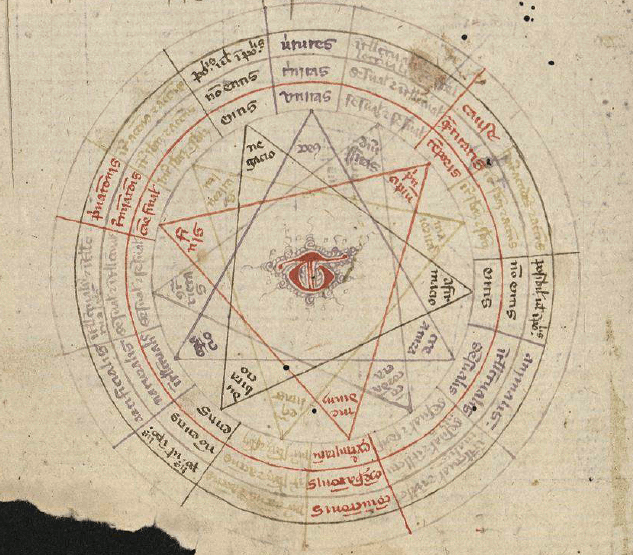

Ars compendiosa inveniendi veritatem XV Century. Palma, BP, 1031. Digital version Biblioteca Virtual del Patrimonio Bibliográfico. Spain. Ministerio de Educación, Cultura y Deporte

Ars compendiosa inveniendi veritatem XV Century. Palma, BP, 1031. Digital version Biblioteca Virtual del Patrimonio Bibliográfico. Spain. Ministerio de Educación, Cultura y Deporte

Ainsi par exemple, au XIIIème siècle, Raymond Lulle imagine une machine « logique » l’Ars Magna constituée de séries de figures géométriques « parfaites » (cercles, carrés, triangles) mise en rotation par une roue et actionnées par des cadrans, des leviers, des manivelles. Les formes sont associées à des théories, des prédications théologiques, des thèses et se positionnaient pour en démontrer la vérité unique ou le caractère impie.

Bien qu’au XVIème siècle, les premiers principes du codage binaire voit le jour avec Francis Bacon et les recherches de simplifications des calculs complexes avec les logarithmes de John Napier donnent leurs premiers résultats, ces réflexions intellectuelles, décorrélées d’usages réels seront peu à peu supplantées par les arts et les techniques. Ainsi l’architecture et la mécanique seront le socle de la plupart des avancées scientifiques ultérieurs.

De l’engrenage à la première calculatrice

Il faut attendre le XVIIème siècle pour voir la première mise en oeuvre fonctionnelle du calcul automatique.

Wilhem Schickard imagine une « horloge automatique calculante », mais Blaise Pascal construit en 1642 la première machine à calculer capable d’effectuer des additions et des soustractions, afin d’aider son père dans son travail de collecteur des impôts.

Exemplaire de la « Pascaline » du musée des Arts et Métiers à ParisCette machine mécanique, la « Pascaline » ou roue de Pascal, utilise des roues dentées qui s’entrainent mutuellement pour mener à bien l’opération souhaitée.

Exemplaire de la « Pascaline » du musée des Arts et Métiers à ParisCette machine mécanique, la « Pascaline » ou roue de Pascal, utilise des roues dentées qui s’entrainent mutuellement pour mener à bien l’opération souhaitée.

De la mécanique à l’electro-mécanique

Il faudra attendre la 2ème révolution industrielle puis ensuite les progrès dans la maitrise de l’électricité pour voir mises en oeuvre de grandes avancées dans le domaine des machines à calculer mécaniques automatiques.

Au cours du XIXème siècle, la Grande-Bretagne vit un siècle de domination sans partage et étend ses possessions et son empire dans le monde entier. Elle connait alors d’important besoins notamment en calculs pour la navigation et l’astronomie.

Les savants de l’époque victorienne vont alors se lancer dans d’importantes recherches dans de très nombreux domaines.

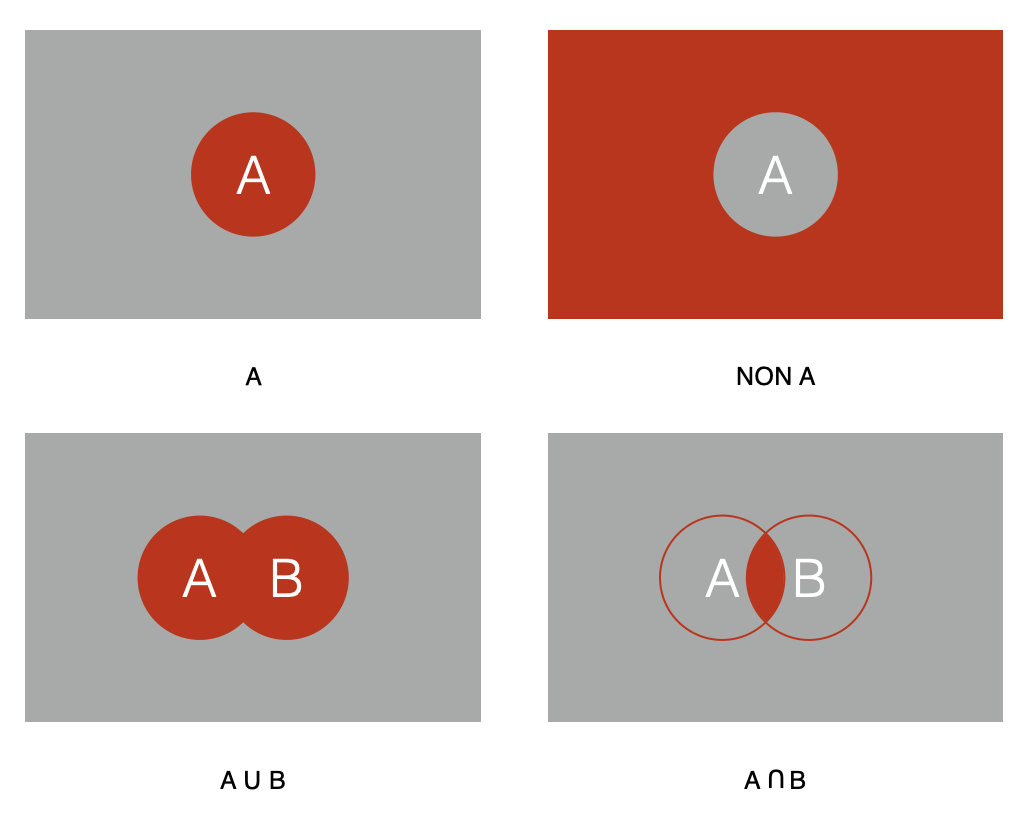

Le logicien anglais Georges Boole publie son livre The Mathematical Analysis of Logic en 1854, où il définit les opérateurs logiques dits «booléens», fondés sur deux valeurs 0/1 pour coder Vrai/Faux.

Différentes idées et évolutions techniques seront proposées mais du fait du décalage entre ce qui sera imaginé et ce qui est réellement réalisable avec les moyens techniques et technologiques de l’époque, elles ne pourront voir le jour.

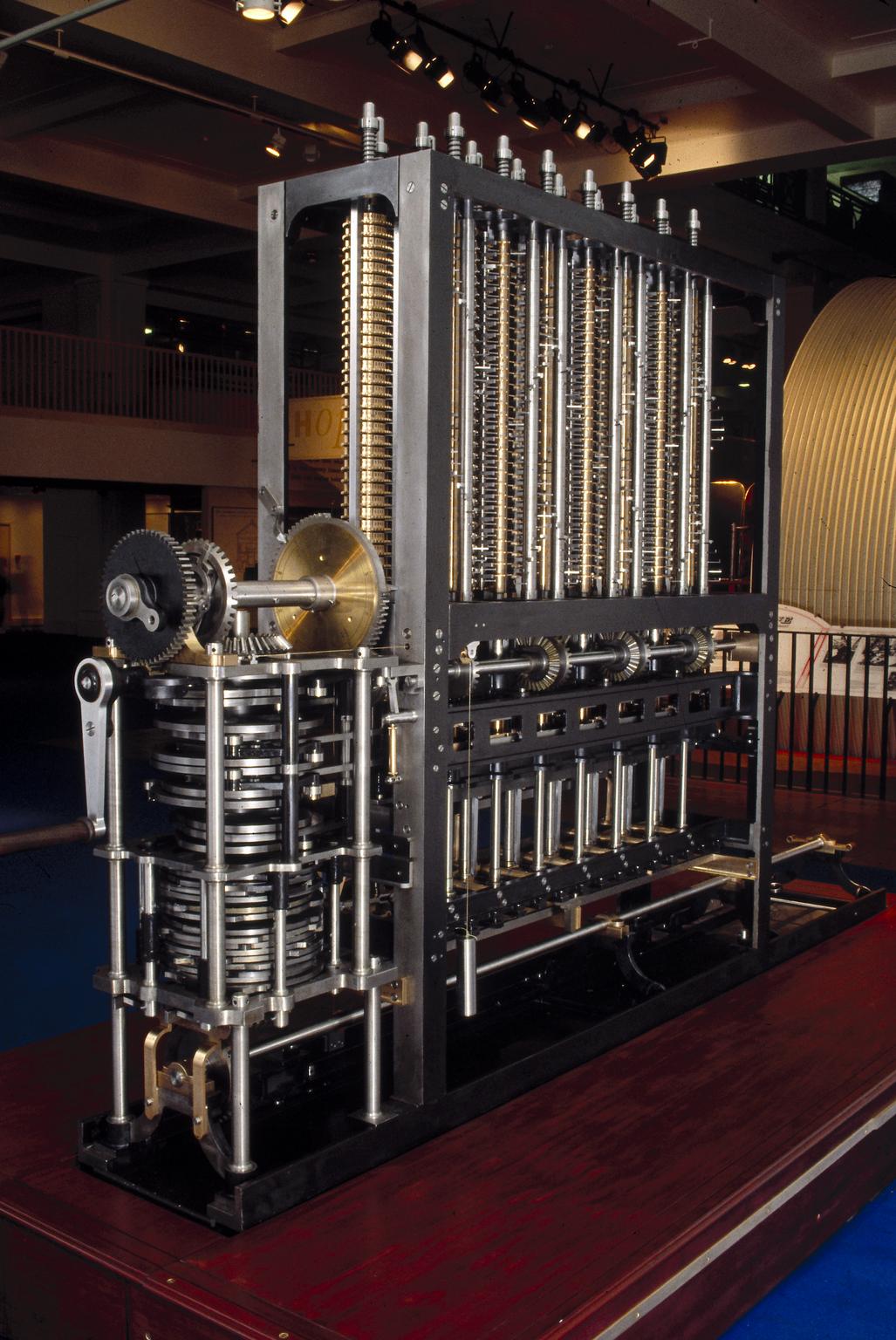

Machine à différence de Charles Babbage construite en 1991. CC BY NC SA Science Museum

Machine à différence de Charles Babbage construite en 1991. CC BY NC SA Science Museum

En particulier, Charles Babbage, ingénieur, conçoit en 1822 les plans d’une première machine, la « machine à différences« .

Utilisant les logarithmes, elle est néanmoins beaucoup trop complexe pour l’époque et ne sera construite d’après les plans originaux qu’en 1991 au Science Museum de Londres.

10 ans plus tard, fort de son succès « virtuel », il imagine alors une nouvelle machine, encore plus performante (et compliquée).

Cet « Analytical Engine » utiliserait des cartes perforées pour enchainer l’exécution d’instructions élémentaires. Ce calculateur mécanique serait donc universel et pourrait « traiter » tout type de tache de calcul complexe.

Il sera aidé dans sa quête par Lady Ada Lovelace.

Fille du poète Lord Byron, par sa position sociale et malgré sa condition de femme, elle peut accéder à l’ensemble des connaissances scientifiques de l’époque et suivre des études. Sa mère la pousse à étudier les mathématiques pour « ne pas finir poète » comme son père avec lequel elle a un très lourd passif… Elle approfondira ses études mathématiques avec le mathématicien Auguste de Morgan, fondateur avec George Boole de la logique moderne appelée « Logique Booléenne ».

Lady Ada Lovelace – Mathématicienne renommée, elle est aujourd’hui considérée comme la première développeuse au monde.

Lady Ada Lovelace – Mathématicienne renommée, elle est aujourd’hui considérée comme la première développeuse au monde.

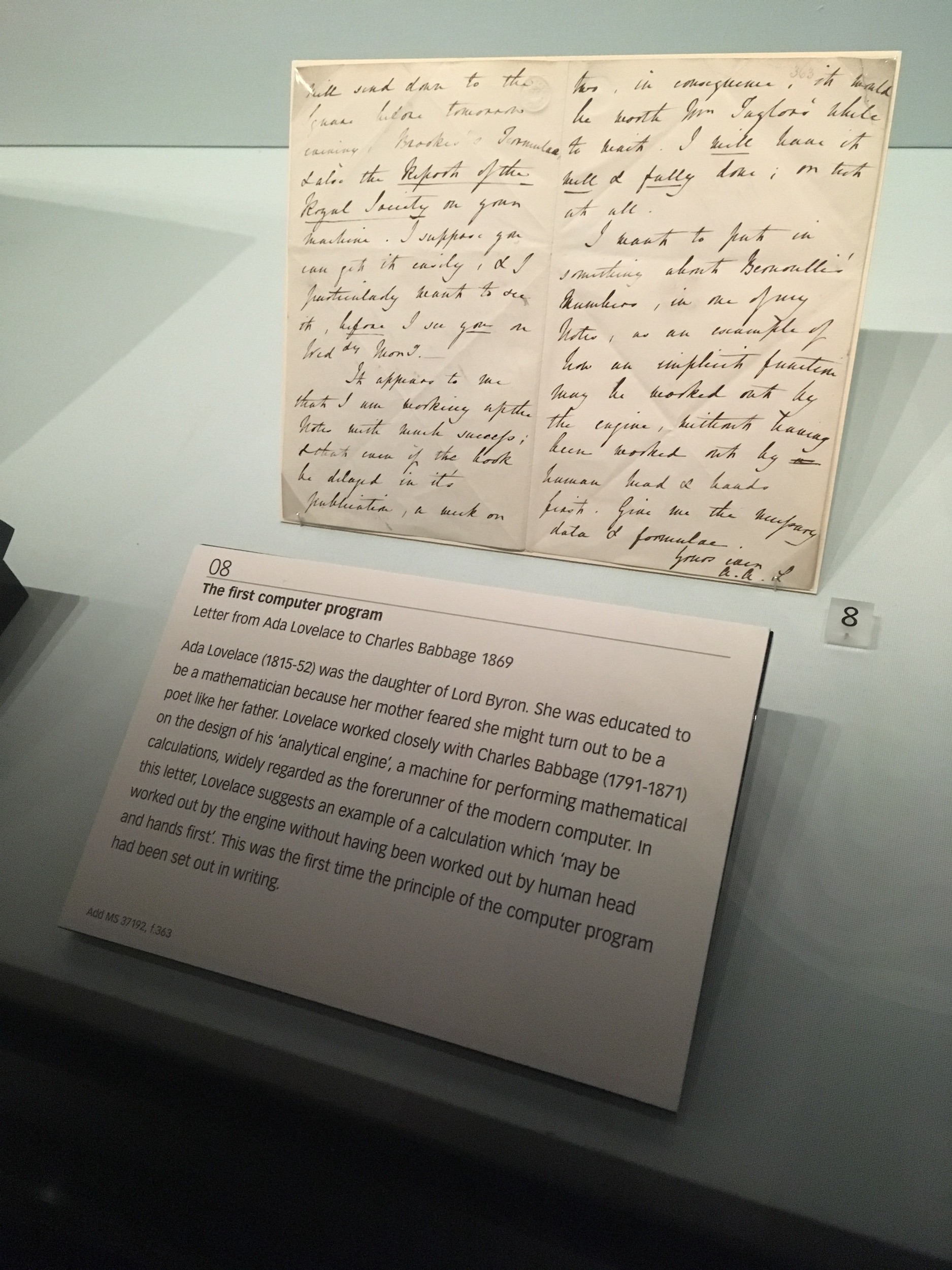

Sur la base des concepts de la nouvelle machine de Charles Babbage, Ada Lovelace va écrire les « premiers programmes » que cette machine aurait pu exécuter.

Lettre originale de son premier programme

Lettre originale de son premier programme

Premier usage à grande échelle des calculateurs mécaniques

Indépendants de la couronne d’Angleterre depuis moins d’un siècle et sortis d’une guerre civile meurtrière de plus de 4 ans, la guerre de sécession entre les états du nord et du sud, les Etats-Unis d’Amérique commencent à connaitre des afflux massifs de migrants depuis l’Europe mais aussi depuis l’Asie.

En place depuis 1790, initialement pour compter les « habitants libres » et les esclaves, mais pas les Indiens, le recensement doit permettre de « répartir les taxes et les sièges des représentants » entre états fédérés du pays en fonction de leurs populations respectives.

Les Etats-Unis cherche à le moderniser car il nécessite de très nombreux mois de comptage et décomptage du fait du traitement manuel. Le recensement de 1880 ne sera achevé qu’en 1888.

Un jeune ingénieur de 24 ans du nom d’Herman Hollerith a déposé un brevet en 1884 sur “l’Art de compiler des statistiques”. Il remporte l’appel d’offre en 1889 pour équiper les bureaux du recensement avec un système innovant.

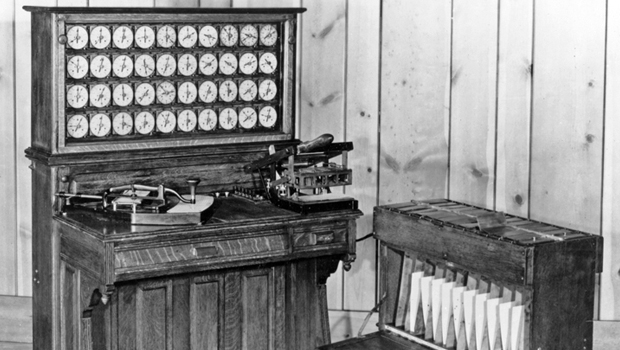

La solution conçue implique une suite de dispositifs mécaniques et électriques.

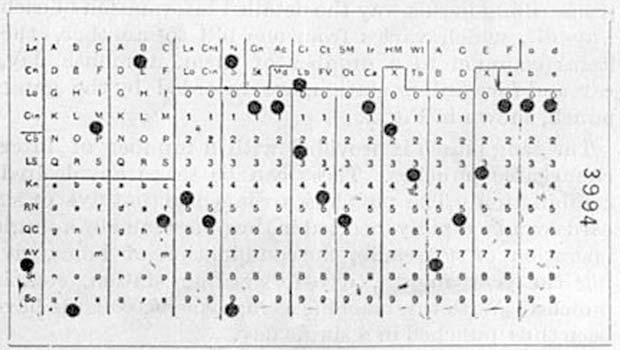

La première innovation cruciale a été de traduire les données des feuilles de pointage manuscrites du recensement en modèles de trous perforés dans les cartes.

Herman Hollerith l’explique dans la révision de 1889 de sa demande de brevet : « Un trou est donc poinçonné correspondant à une personne, puis un trou selon que la personne est un homme ou une femme, un autre enregistrement qu’il soit natif ou étranger, un autre blanc ou de couleur, etc. »

Carte perforée du recensement de 1890

Carte perforée du recensement de 1890

Il développe une machine spéciale pour garantir que les trous puissent être perforés avec précision et efficacité.

Le système de perforation des cartesL’autre machine «lit» la carte, en sondant la carte avec des broches électriques. Là où il y a un trou, la broche passe à travers la carte pour établir une connexion, ce qui a pour résultat de faire avancer le compteur mécanique approprié.

Le système de perforation des cartesL’autre machine «lit» la carte, en sondant la carte avec des broches électriques. Là où il y a un trou, la broche passe à travers la carte pour établir une connexion, ce qui a pour résultat de faire avancer le compteur mécanique approprié.

La « tabulatrice » comptabilisant les différents « détails »

La « tabulatrice » comptabilisant les différents « détails »

Le recensement de 1890 se déroula si rapidement que les résultats, état par état, nécessaires à la répartition du Congrès, furent certifiés avant la fin du mois de novembre 1890.

Fort de son succès, Herman Hollerith fonde the Tabulating Machine Company et commercialise aux grandes entreprises aux Etats-Unis ses machines puis les exporte vers de très nombreux pays.

En 1924, l’entreprise change de nom pour s’appeler International Business Machine qui rapidement deviendra IBM.

Ce système sera à peine modernisé au fil des recensements jusqu’aux années 1950.

Les cartes perforées seront couramment utilisées en informatique jusqu’au début des années 1980.

XXème siècle : progrès scientifiques et évolutions

Il faut attendre l’entre deux guerre, à partir des années 1920 pour que différents progrès dans les domaines des sciences et des techniques permettent d’envisager de nouvelles applications à l’automatisation des calculs.

Les découvertes en physique (ondes, atomes, électrons, rayonnements, radioactivité…) et les progrès dans leurs applications techniques et technologiques vont apporter de nouveau axes de recherches d’applications et de progrès au XXème siècle.

Les systèmes mécaniques se modernisent petit à petit au court de la première moitié du XXème siècle avec les progrès dans la maitrise de l’électricité qui donneront naissance à l’électronique.

1925 : Vannevar Bush, ingénieur américain, construit un calculateur analogique au MIT

1925 : Vannevar Bush, ingénieur américain, construit un calculateur analogique au MIT

Ces progrès avec l’électricité permettent d’améliorer la mécanisation à l’aide de moteurs électriques et les systèmes de connections et de communication par une meilleure conductivité des composants utilisés.

A la veille de la 2nde guerre mondiale

)

)

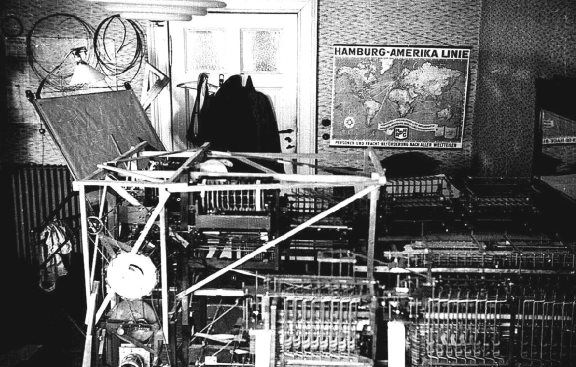

Konrad Zuse, ingénieur allemand entreprend en 1936 la construction d’un calculateur automatique, le Z1, qui verra le jour en 1938.

Système informatique d’origine Z1 dans le salon des parents de Konrad Zuse à Berlin

Système informatique d’origine Z1 dans le salon des parents de Konrad Zuse à Berlin

En 1938, Claude Shannon, 21 ans, est le premier à expliquer comment traduire la logique booléenne sous forme de circuits électriques en utilisant des relais électromécaniques.

Claude Shannon – Wikimedia CommonsAutrement dit, comment utiliser l’électricité pour faire un ordinateur…

Claude Shannon – Wikimedia CommonsAutrement dit, comment utiliser l’électricité pour faire un ordinateur…

William Hewlett et David Packard fonde en le 1er janvier 1939 Hewlett Packard, société qui conçoit, fabrique et commercialise des instruments d’essai et de mesure électroniques qui s’installe dans le garage de David Packard à Palo Alto.

William Hewlett et David Packard fonde en le 1er janvier 1939 Hewlett Packard, société qui conçoit, fabrique et commercialise des instruments d’essai et de mesure électroniques qui s’installe dans le garage de David Packard à Palo Alto.

Même année, John Atanassoff et Clifford Berry, son étudiant, conçoivent un prototype appelé ABC à l’université de l’Iowa, reconnu comme le premier prototype d’ordinateur.

ABC, premier prototype d’ordinateur

ABC, premier prototype d’ordinateur

En parallèle, les médias et les moyens de communication se développement de plus en plus.

La radiodiffusion est opérationnelle à partir du début du XXème siècle et deviens un média de masse à partir des années 30. La télévision verra le jour après la 1ère guerre mondiale et s’implantera dans les foyers occidentaux après la 2nde guerre mondiale.

Alan Turing et Enigma

Alan Mathison Turing – Wikimedia CommonsAlan Mathison Turing est une des grandes figures du XXIème siècle qui n’a connu une reconnaissance progressive que depuis les années 1990.

Alan Mathison Turing – Wikimedia CommonsAlan Mathison Turing est une des grandes figures du XXIème siècle qui n’a connu une reconnaissance progressive que depuis les années 1990.

Il est pourtant désormais identifié comme un des pères de l’informatique moderne.

Très sportif, élève brouillon et inattentif mais passionné de sciences et de mathématique, Alan Turing réussit à entrer en 1931 au King’s College de Cambridge et s’y épanoui.

Il s’intéresse aux travaux sur la mécanique quantique, et étudie les probabilités et la logique.

En 1935, Alan Turing travaille sur la calculabilité des grands nombres et met au point le concept d’une machine universelle, s’appuyant sur les algorithmes pour résoudre les problèmes. C’est la machine de Turing.

Cette idée a donné naissance aux ordinateurs modernes, qui en sont la réalisation concrète et fonctionnelle.

Machine de turing en lego – Rubens Project/Wikimedia Commons

Machine de turing en lego – Rubens Project/Wikimedia Commons

Après son doctorat à Princeton (Etats-Unis), Alan Turing revient en Angleterre en 1938. La Grande Bretagne, face à la montée du nazisme, développe des armes et de nouvelles techniques de chiffre et de cryptanalyse en particulier pour contrer l’usage des machines Enigma de chiffrage utilisées par les allemands.

Alan Turing fait partie des « cerveaux » recrutés (chercheurs, linguistes, joueurs d’échecs…) qui rejoignent Bletchley Park, centre secret de la Government Code and Cypher School.

Machine Enigma de la marine allemande à 4 disques – Greg Goebel/Wikimedia Commons

Machine Enigma de la marine allemande à 4 disques – Greg Goebel/Wikimedia Commons

La machine Enigma allemande est l’un des plus important problème pour les alliés durant la guerre.

Chaque jour le code, la combinaison de l’agencement des disques rotatifs et du câblage associé, est modifié.

Ces machines étaient utilisées pour chiffrer et déchiffrer à la volée les messages échangés.

Les alliés n’ont donc que 24 heures pour déchiffrer le code avant sa réinitialisation le lendemain.

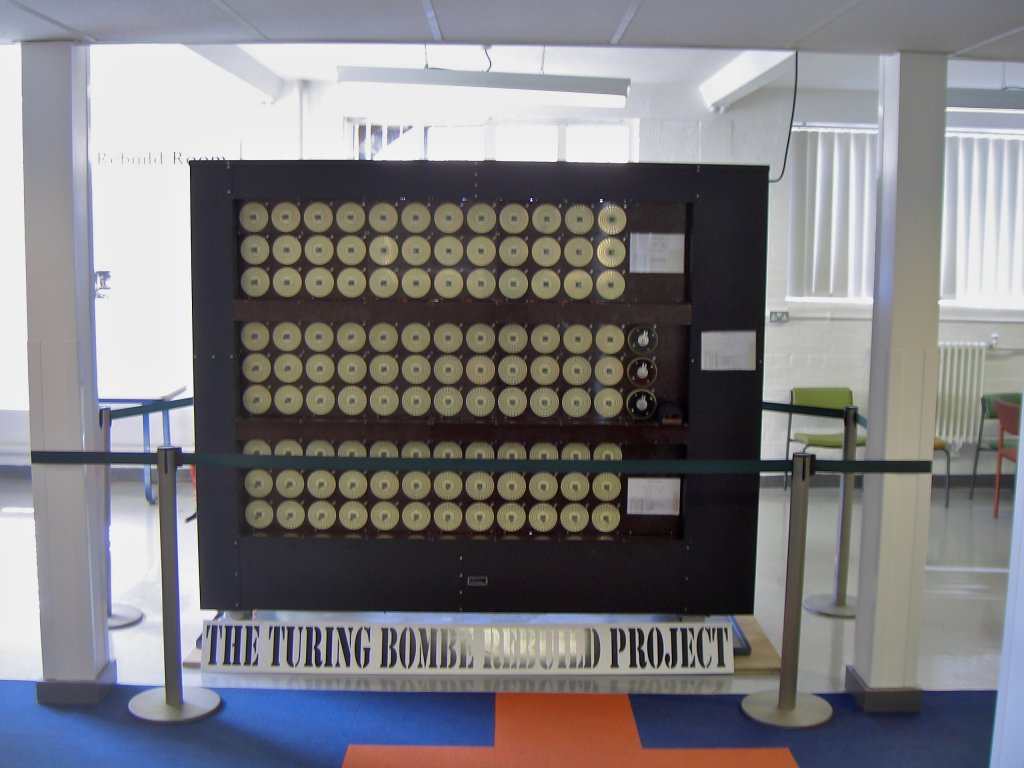

Alan Turing reprend une machine électro-mécanique polonaise « la Bomba » et la perfectionne pour lui permettre de « casser » le code.

Deux autres mathématiciens, George Welchman et Richerd Pendered, l’améliorent ensuite à leur tour et en font l’outil ultime pour déchiffrer des parties des messages et ainsi trouver le code.

The Turing Bombe Rebuild Project

The Turing Bombe Rebuild Project

Les anglais ne sont pas les seuls durant cette période à lancer de nombreuses recherches dans le domaine de l’automatisation des calculs.

Des machines et des hommes révolutionnaires

Les différents projets se multiplient dans les années 1940 afin de satisfaire le décryptage mais aussi les calculs balistiques et l’ensemble des besoins de calculs militaires…

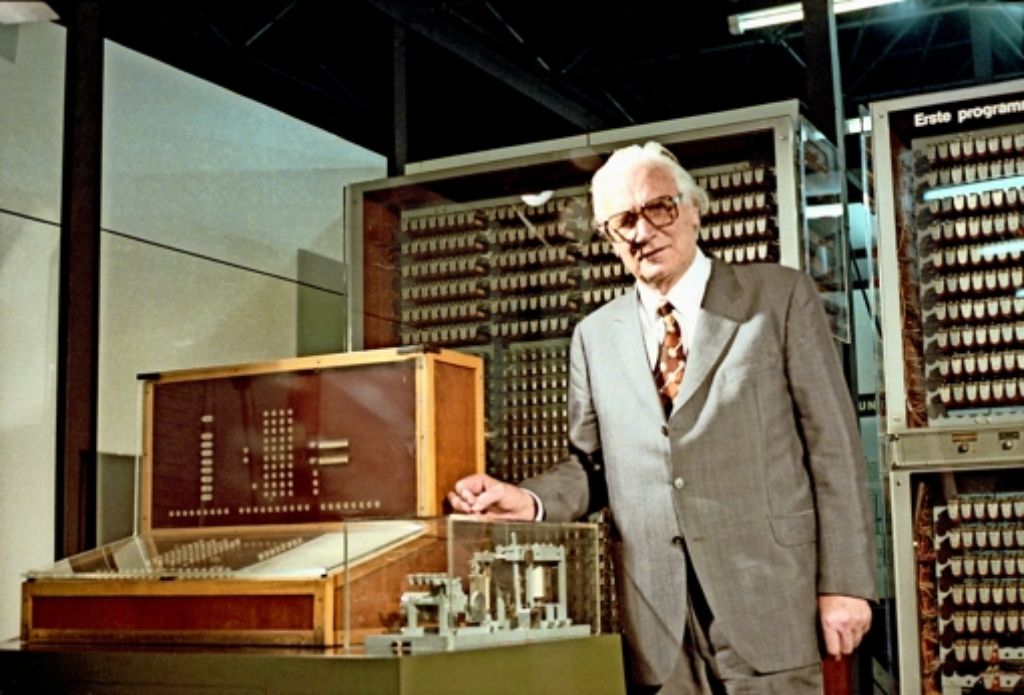

Konrad Zuse est l’un des pionniers du calcul programmable qui préfigure l’informatique. Inventeur du Z3 en 1941, il est considéré comme le créateur du premier ordinateur programmable en calcul binaire et à virgule flottante.

Konrad Zuse se tient à côté d’une réplique de son ordinateur Z3 au Deutsches Museum de Munich, l’original ayant été détruit pendant la Seconde Guerre mondiale en 1943 – Deutsches Museum

Konrad Zuse se tient à côté d’une réplique de son ordinateur Z3 au Deutsches Museum de Munich, l’original ayant été détruit pendant la Seconde Guerre mondiale en 1943 – Deutsches Museum

John Von Neuman devant le Mathematical and Numerical Integrator and Calculator (MANIAC) qu’il a conçu.

John Von Neuman devant le Mathematical and Numerical Integrator and Calculator (MANIAC) qu’il a conçu.

John Von Neumann, travaille sur les calculs nécessaires au projet Manhattan et en 1945, il écrit un rapport où il propose l’architecture interne d’un calculateur universel, appelée désormais «architecture de Von Neumann».

L’ENIAC, construit en 1946 à l’Université de Pennsylvanie, est le dernier gros calculateur électrique programmable (mais pas universel), il fait 30 tonnes, occupe 160m2 et sa mémoire est constituée de 18 000 tubes à vide.

Sa puissance de calcul est équivalente à celle d’une petite calculette actuelle.

Glen Beck et Betty Snyder face à l’ENIAC – U.S. Army

Glen Beck et Betty Snyder face à l’ENIAC – U.S. Army

Pendant ce temps, Wallace Eckler et John Mauchly conçoivent le Binac (Binary Automatic Computer), qui opère pour la première fois «en temps réel». Il ne sera construit qu’avec l’apport de Von Neumann pour être vendu à Northrop Aircraft en septembre 1949.

Le transistor

L’invention du transistor en 1947 est une véritable révolution technologique. Agissant comme un interrupteur miniature commandable à distance par le biais d’un courant électrique, il va transformer la conception des ordinateurs et permettre le développement de nouvelles machines beaucoup plus efficaces.

Réplique du premier transistor créé le 23 décembre 1947 – Laboratoires Bell / Lucent

Réplique du premier transistor créé le 23 décembre 1947 – Laboratoires Bell / Lucent

La logique booléenne avec des circuits électriques mise au point par Claude Shannon en 1938 peut être mise en application à très grande échelle désormais.

Claude Shannon, encore lui…, publie en 1948 sa Théorie mathématique de l’information, où est introduite la notion de quantité d’information d’un objet et sa mesure en bits ; ces contributions majeures à l’informatique moderne en font de lui le père de la théorie de l’information.

L’année suivante, il construit la première machine à jouer aux échecs

A partir de cette date, l’ordinateur existe et son histoire matérielle se réduit donc à l’évolution des progrès technologiques, qu’on découpe habituellement en termes de «générations».

- Tubes à vides et tableaux d’interrupteurs (1945 – 1955) : les « monstres »- Ils ne possèdent pas de système d’exploitation ni de langage spécifique de programmation.

- L’entrée des instructions de calcul s’opère avec les différents interrupteurs électriques et à partir des années 50, l’utilisation des cartes perforées permet la première « écriture » de programmes.

- Les tubes à vide pour la mémoire sont extrêmement fragiles et occupent énormément d’espace.

- Transistors et systèmes par lots (1955 – 1965)- Les ordinateurs deviennent suffisamment fiables pour être produits, vendus et utilisés par des opérateurs et des programmeurs

- Les systèmes d’exploitations font leur apparition et reposent sur le premier langage de programmation créé en 1954, le FORTRAN qui permet de « compiler » différentes tâches.

- Circuits intégrés – Multiprogrammation – Temps partagé (1965 – 1980)- Les ordinateurs sont de plus en plus couramment utilisés, pour de la gestion et du calcul, ce qui occasionne des difficultés de traitement des tâches imposant la multiprogrammation puis le temps partagé.

- La volonté d’uniformisation des machines et des systèmes se heurte aux besoins qui diffèrent et l’apparition des mini-ordinateurs va ouvrir la voie à de nouveaux usages en entreprises.

- Micro-ordinateur et Personal Computer (PC)- L’augmentation du nombre de transistors dans les circuits intégrés permet d’offrir des capacités de calcul de plus en plus importantes en occupant de moins en moins d’espace, à des coûts de plus en plus accessibles. Ils deviennent ainsi des micro-ordinateurs.

- L’ordinateur devient « personnel », s’ancre définitivement dans les entreprises et commence à entrer dans les foyers.

Les avancées conceptuelles les plus spectaculaires concernent, elles, principalement la conception de nouveaux langages de programmation évolués. Ces langages évolués répondent aux besoins qui se développent avec l’explosion des usages.

Cas de l’Intelligence Artificielle

L’IA trouve ses racines dans la volonté humaine d’automatiser le traitement d’informations. Depuis la construction d’automates, avec l’aide de la réflexion sur la logique et ses conséquences, à l’élaboration de machines à calculer… à apprendre et à « penser ».

Après la guerre, Alan Turing travaille à l’institut de Physique de Grande-Bretagne à la conception des premiers ordinateurs. Il s’intéresse également à la biologie, et plus particulièrement aux connexions neuronales et à la mise en oeuvre de la pensée et de la conscience.

Dans les années 1950, Alan Turing dans un essai Computing Machinery and Intelligence qui soulève la question de reconnaitre aux machines une forme d’intelligence : l’Intelligence Artificielle.

Comparaisons des niveaux de « réflexion » humaine et artificielleAinsi, l’intelligence artificielle (IA) vise donc à reproduire au mieux, à l’aide de machines, des activités mentales, qu’elles soient de l’ordre de la mémorisation, de la compréhension et de la perception, de l’apprentissage, de l’analyse raisonnée et / ou de la décision.

Comparaisons des niveaux de « réflexion » humaine et artificielleAinsi, l’intelligence artificielle (IA) vise donc à reproduire au mieux, à l’aide de machines, des activités mentales, qu’elles soient de l’ordre de la mémorisation, de la compréhension et de la perception, de l’apprentissage, de l’analyse raisonnée et / ou de la décision.

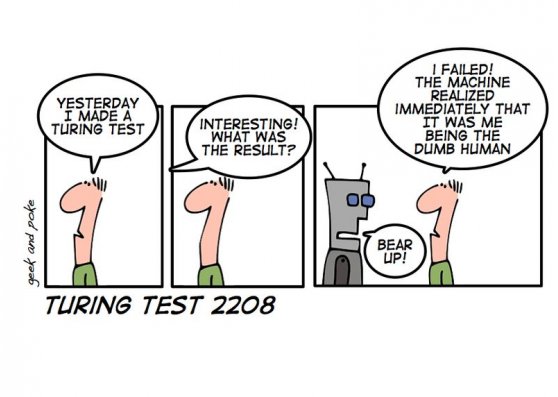

Il met au point un test, le test de Turing, qui permettrait d’identifier cette intelligence en laissant un premier individu intéragir sans contacts avec un autre individu et une machine. Si la machine arrive à tromper le premier individu en se faisant passer pour le second, alors elle a « réussi » le test.

Ce test est considéré comme une sorte de « graal » pour les IA et est souvent traité de manière humoristique pour envisager le monde d’après… dans lequel les machines auront supplantés les humains sur le plan de l’intelligence… et sur les autres plans. Ce débordement des machines sur l’esprit humain est le sujet de nombreuses controverses : éthiques, philosophiques, politiques…

> En cours de rédaction

> En cours de rédaction